Ferma i robot arrabbiati come 360Spider per eseguire la scansione del mio sito

Il mio sito web steakovercooked.com è stato su uno dei server di hosting condiviso di fasthosts. Di recente, il mio sito è stato disabilitato molte volte a causa di un numero enorme di richieste al mio sito. Questi provengono principalmente dal bot che esegue la scansione del sito. L’ingegnere delle operazioni IT di Fasthosts Ewan MacDonald mi ha inviato una mail e ha detto:

Caro justyy

Non sono sicuro di cosa stai facendo esattamente con il tuo sito, ma hai consumato oltre il 75% dei processi Apache disponibili. Ciò ha causato enormi problemi a tutti gli altri clienti sul server web.

Sto eseguendo una scansione di sicurezza sul tuo sito in questo momento.

Tieni presente che il tuo sito ne contiene 85.000 pari a 8,6 GB. I nostri termini affermano che tutti i file nel tuo spazio web devono far parte del sito Web, quindi tutti gli 85.000 file fanno parte del sito e sono accessibili tramite il sito? In caso contrario, devono essere rimossi per favore.

Rimuoverò anche le 2 cartelle rinominate htdocs a meno che tu non ti opponga?

Se il tuo sito causa lo stesso problema di prestazioni mentre la scansione è in esecuzione, lo porterò nuovamente offline finché non sarai in grado di fornire una spiegazione del motivo per cui sta vincolando circa 200 processi Apache.

Distinti saluti,

Quindi, ho controllato il log di apache2 e ne ho trovati molti di questi:

[Mer Jul 23 21:40:21 2014] [avviso] mod_fcgid: impossibile applicare lo slot di processo per /var/www/fcgi/php54-cgi

[Mer Jul 23 21:40:22 2014] [avviso] mod_fcgid: può ‘t apply process slot for /var/www/fcgi/php54-cgi

[Wed Jul 23 21:40:30 2014] [warn] mod_fcgid: impossibile applicare process slot per /var/www/fcgi/php54-cgi

[ Wed Jul 23 21:40:31 2014] [warn] mod_fcgid: impossibile applicare lo slot di processo per /var/www/fcgi/php54-cgi

[Wed Jul 23 21:40:31 2014] [warn] mod_fcgid: can’ t applicare lo slot di processo per /var/www/fcgi/php54-cgi

[Mer Jul 23 21:40:31 2014] [avviso] mod_fcgid: impossibile applicare lo slot di processo per /var/www/fcgi/php54-cgi

Apparentemente, sembra che 360spider abbia colpito il sito in modo piuttosto pesante e ovviamente influisca su altri siti Web sullo stesso host condiviso, ed è per questo che i fasthost devono eliminare il mio sito.

Il problema 360spider è tornato più tardi, quindi hanno dovuto disabilitare di nuovo il mio sito finché non ho uno script pronto per bloccarne l’accesso poiché sta causando problemi ad altri utenti del server.

Mi dispiace che ciò causi problemi ad altri host di condivisione, ma secondo me potrebbe essere meglio bloccarli utilizzando un livello superiore (es. impostazioni di apache). Immagina, qualsiasi altro sito Web potrebbe incontrare lo stesso problema. In precedenza ho ottimizzato il mio sito Web per ridurre l’utilizzo della CPU memorizzandoli nella cache in HTML statici. ma a causa di un certo numero di pagine (circa 5000 segnalate in google webmaster), alcuni spider potrebbero non essere abbastanza intelligenti da capire il duplicato. Gli spider di Google vanno bene perché posso configurare i parametri e obbediscono al file robots.txt. Ma per questi ragni arrabbiati (ad esempio 360, youdao), in realtà non obbediscono del tutto alle regole di scansione.. L’unico modo per bandirli è contrassegnarli nella lista nera (posso farlo di sicuro). ma per altri utenti, potrebbero dover affrontare lo stesso problema.

robots.txt

Il robots.txt è un file di testo sotto la radice del sito Web che indirizza i robot di ricerca su quali directory indicizzare e quali non sono consentite. Ma non tutti i robot seguono le "istruzioni". Ecco le regole che aggiungo per dire a questi cattivi robot che se ne vanno.

# root

User-agent: *

Crawl-Delay: 1

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

User-agent: 360Spider

Disallow: /

User-agent: YoudaoBot

Disallow: /

User-agent: sogou spider

Disallow: /

User-agent: YisouSpider

Disallow: /

User-agent: LinksCrawler

Disallow: /

User-agent: EasouSpider

Disallow: /.htaccess

Il file .htaccess è un file di testo e nascosto in ogni directory del sito web. Viene utilizzato dal modulo di riscrittura di Apache mod_rewrite per rendere gli URL più belli. Può essere utilizzato anche per controllare questi robot.

codice PHP

Come precauzione di sicurezza, ho anche inserito il seguente codice in index.php che viene utilizzato per generare pagine diverse in base ai parametri URL. Il 99% delle pagine del sito Web viene generato utilizzando questo file di indice.

$agent='';

if (isset($_SERVER['HTTP_USER_AGENT']))

{

$agent = $_SERVER['HTTP_USER_AGENT'];

}

define('BADBOTS','/(yisouspider|easouspider|yisou|youdaobot|yodao|360|linkscrawler|soguo)/i');

if (preg_match(BADBOTS, $agent)) {

die();

} Fondamentalmente, ciò che fa il PHP sopra è controllare la stringa HTTP_USER_AGENT contro questi bot dannosi. Il preg_match utilizza un’espressione regolare e l’opzione /i specifica confronti senza distinzione tra maiuscole e minuscole.

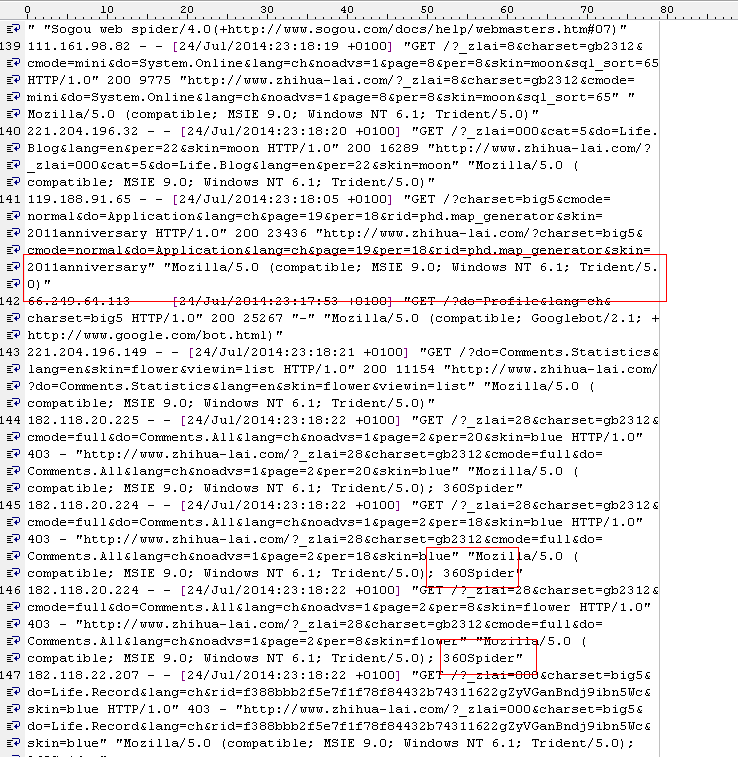

Ho anche notato che nel file di registro ci sono molte voci come questa:

119.188.91.121 – – [24/Jul/2014:22:39:51 +0100] “GET /?charset=big5&do=System.Online&lang=ch&page =25&per=10&skin=2011anniversario HTTP/1.0" 200 3919 ” https://steakovercooked.com/ … …" “~Mozilla/5.0 (compatibile; MSIE 9.0; Windows NT 6.1; Trident/5.0)~”

Da HTTP_USER_AGENT normalmente pensi che non sia un bot, ma penso che lo siano. Quindi questi robot sono molto cattivi. In realtà daranno qualsiasi USER_AGENT (possono cambiare questo valore) e di solito provengono da più IP (quindi non è facile identificarli tutti usando intervalli IP specifici).

Sembra funzionare dopo i metodi di cui sopra.

sembra funzionare, perché nel registro di apache ne trovo molti

[gio lug 24 23:01:02 2014] [errore] [client 61.135.189.186] client negato dalla configurazione del server: /home/linweb09/z/steakovercooked. com-1048918357/user/htdocs/

[gio lug 24 23:01:02 2014] [errore] [client 61.135.189.186] client negato dalla configurazione del server: /home/linweb09/z/steakovercooked.com-1048918357/user/htdocs /errore

[gio 24 luglio 23:01:08 2014] [errore] [client 61.135.189.186] client negato dalla configurazione del server: /home/linweb09/z/steakovercooked.com-1048918357/user/htdocs/

E anche i fasthost sono contenti: “Sì, ora sta molto meglio. quindi chiuderò questo biglietto. Molte grazie per la tua azione.

Tuttavia, questa potrebbe non essere una soluzione finale … Alla fine, sposterò anche questo sito su VPS, server di bilanciamento del carico o server dedicato in modo che non venga rimosso a causa di questo stupido motivo.

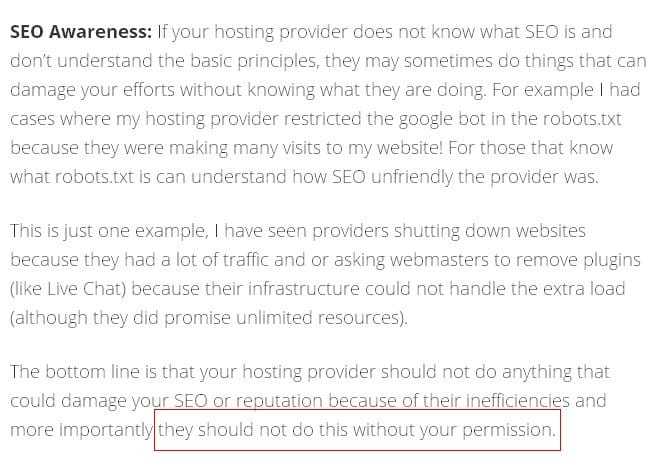

L’altro giorno, ho letto il paragrafo seguente e non potrei essere più d’accordo su questo: la società di web hosting NON dovrebbe fare nulla per danneggiare la reputazione SEO dei tuoi siti Web, per non parlare del fatto che l’intero sito non funziona senza i tuoi permessi. Fasthosts è appena oltre il limite ed è per questo che fasthosts ha ricevuto così tante recensioni negative (qualcosa come spazzatura, merda, scappa per tutta la vita).

A proposito, sto usando QuickHostUK, che è semplicemente il migliore. Il VPS funziona alla grande e ho già spostato un paio di siti.