Arrêtez les robots en colère tels que 360Spider pour explorer mon site

Mon site Web steakovercooked.com a été sur l’un des serveurs d’hébergement partagé fasthosts. Récemment, mon site a été désactivé plusieurs fois en raison d’un grand nombre de demandes sur mon site. Celles-ci proviennent principalement de robots explorant le site. L’ingénieur des opérations informatiques de Fasthosts, Ewan MacDonald, m’a envoyé un e-mail et m’a dit :

Cher justyy

Je ne sais pas exactement ce que vous faites avec votre site, mais vous avez consommé plus de 75 % des processus Apache disponibles. Cela a causé d’énormes problèmes à tous les autres clients du serveur Web.

J’exécute actuellement une analyse de sécurité sur votre site.

Veuillez noter que votre site en contient 85 000, soit 8,6 Go. Nos conditions stipulent que tous les fichiers de votre espace Web doivent faire partie du site Web. Par conséquent, les 85 000 fichiers font-ils tous partie du site et sont-ils accessibles via le site ? Si ce n’est pas le cas, ils doivent être supprimés s’il vous plaît.

Je vais également supprimer les 2 dossiers htdocs renommés, sauf si vous vous y opposez ?

Si votre site pose le même problème de performances pendant l’exécution de l’analyse, je le mettrai à nouveau hors ligne jusqu’à ce que vous puissiez expliquer pourquoi il bloque environ 200 processus Apache.

Meilleures salutations,

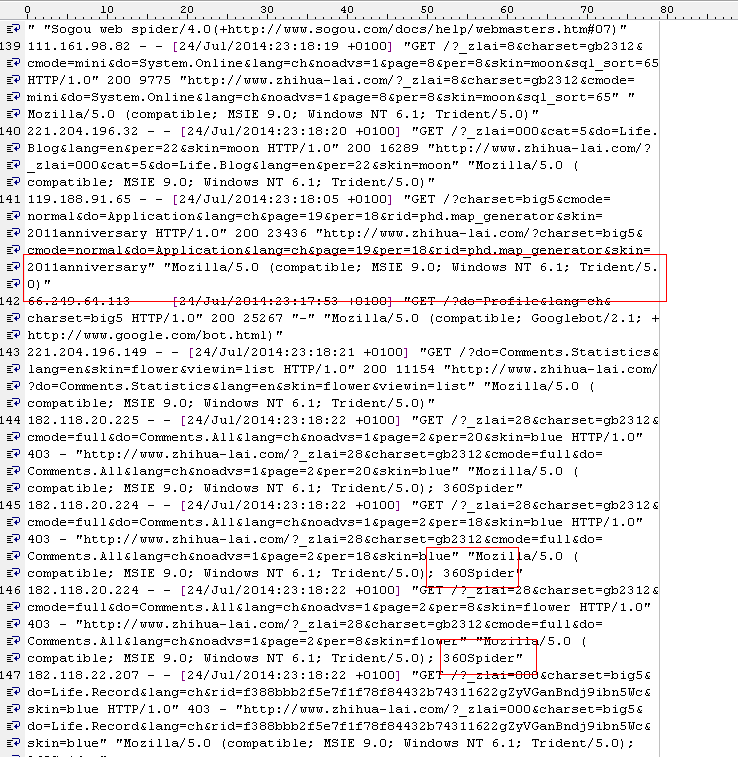

Ensuite, j’ai vérifié le journal apache2, et j’en trouve beaucoup :

[Wed Jul 23 21:40:21 2014] [warn] mod_fcgid : impossible d’appliquer l’emplacement de processus pour /var/www/fcgi/php54-cgi

[Wed Jul 23 21:40:22 2014] [warn] mod_fcgid : peut ‘t apply process slot for /var/www/fcgi/php54-cgi

[Wed Jul 23 21:40:30 2014] [warn] mod_fcgid: can’t apply process slot for /var/www/fcgi/php54-cgi

[ Mer 23 juillet 21:40:31 2014] [warn] mod_fcgid : impossible d’appliquer l’emplacement de processus pour /var/www/fcgi/php54-cgi

[Mer 23 juillet 21:40:31 2014] [warn] mod_fcgid : can’t t apply process slot for /var/www/fcgi/php54-cgi

[Wed Jul 23 21:40:31 2014] [warn] mod_fcgid: can’t apply process slot for /var/www/fcgi/php54-cgi

Apparemment, il semble que 360spider frappe assez lourdement le site et cela affecte évidemment d’autres sites Web sur le même hôte partagé, et c’est pourquoi les fasthosts doivent supprimer mon site.

Le problème de 360spider est revenu plus tard, ils ont donc dû désactiver à nouveau mon site jusqu’à ce que j’aie un script prêt à bloquer son accès car cela cause des problèmes aux autres utilisateurs du serveur.

Je suis désolé que cela cause des problèmes aux autres hébergeurs de partage, mais à mon avis, il serait peut-être préférable de les bloquer en utilisant un niveau supérieur (par exemple, les paramètres apache). Imaginez, tout autre site Web peut rencontrer le même problème. J’ai déjà optimisé mon site Web afin de réduire l’utilisation du processeur en les mettant en cache dans des HTML statiques. mais en raison d’un certain nombre de pages (environ 5000 signalées dans google webmaster), certaines araignées peuvent ne pas être assez intelligentes pour comprendre le doublon. Les araignées de Google vont bien car je peux configurer les paramètres et elles obéissent au fichier robots.txt. Mais pour ces araignées en colère (par exemple 360, youdao), elles n’obéissent pas tout à fait aux règles d’exploration. La seule façon de les bannir est de les marquer dans la liste noire (je peux le faire à coup sûr). mais pour d’autres utilisateurs, ils peuvent rencontrer le même problème.

robots.txt

Le robots.txt est un fichier texte sous la racine du site Web qui dirige les robots de recherche vers les répertoires à indexer et ceux qui ne sont pas autorisés. Mais tous les bots ne suivent pas les "instructions". Voici les règles que j’ajoute pour dire à ces mauvais bots de disparaître.

# root

User-agent: *

Crawl-Delay: 1

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

User-agent: 360Spider

Disallow: /

User-agent: YoudaoBot

Disallow: /

User-agent: sogou spider

Disallow: /

User-agent: YisouSpider

Disallow: /

User-agent: LinksCrawler

Disallow: /

User-agent: EasouSpider

Disallow: /.htaccess

Le fichier .htaccess est un fichier texte et caché dans chaque répertoire de site Web. Il est utilisé par le module de réécriture apache mod_rewrite pour rendre les URL plus belles. Il peut également être utilisé pour contrôler ces bots.

Code PHP

Par mesure de sécurité, j’ai également mis le code suivant à l’ index.php qui est utilisé pour générer différentes pages en fonction des paramètres d’URL. 99% des pages du site Web sont générées à l’aide de ce fichier d’index.

$agent='';

if (isset($_SERVER['HTTP_USER_AGENT']))

{

$agent = $_SERVER['HTTP_USER_AGENT'];

}

define('BADBOTS','/(yisouspider|easouspider|yisou|youdaobot|yodao|360|linkscrawler|soguo)/i');

if (preg_match(BADBOTS, $agent)) {

die();

} Fondamentalement, ce que fait le PHP ci-dessus est de vérifier la chaîne HTTP_USER_AGENT par rapport à ces mauvais bots. Le preg_match utilise une expression régulière et l’option /i spécifie des comparaisons insensibles à la casse.

J’ai également remarqué dans le fichier journal, il y a pas mal d’entrées comme celle-ci :

119.188.91.121 – – [24/Jul/2014:22:39:51 +0100] «GET /?charset=big5&do=System.Online&lang=ch&page =25&per=10&skin=2011anniversary HTTP/1.0" 200 3919 " https://steakovercooked.com/ … …" "~Mozilla/5.0 (compatible ; MSIE 9.0 ; Windows NT 6.1 ; Trident/5.0)~"

À partir de HTTP_USER_AGENT, vous pensez normalement que ce n’est pas un bot, mais je pense qu’ils le sont. Ces bots sont donc très mauvais. Ils donneront en fait n’importe quel USER_AGENT (ils peuvent changer cette valeur) et ils proviennent généralement de plusieurs adresses IP (il n’est donc pas facile de les identifier toutes à l’aide de plages d’adresses IP spécifiques).

Cela semble fonctionner après les méthodes ci-dessus.

cela semble fonctionner, car dans le journal apache, j’en trouve beaucoup

[Jeu 24 juillet 23:01:02 2014] [erreur] [client 61.135.189.186] client refusé par la configuration du serveur: /home/linweb09/z/steakovercooked. com-1048918357/user/htdocs/

[Jeu 24 juillet 23:01:02 2014] [erreur] [client 61.135.189.186] client refusé par la configuration du serveur: /home/linweb09/z/steakovercooked.com-1048918357/user/htdocs /error

[Thu Jul 24 23:01:08 2014] [error] [client 61.135.189.186] client refusé par la configuration du serveur : /home/linweb09/z/steakovercooked.com-1048918357/user/htdocs/

Et le fasthosts est également ravi: «Ouaip, ça va beaucoup mieux maintenant. donc je ferme ce ticket. Un grand merci pour votre action."

Cependant, ce n’est peut-être pas une solution définitive… A terme, je déplacerai également ce site vers des VPS, des serveurs de répartition de charge ou un serveur dédié afin qu’il ne soit pas supprimé à cause de cette raison stupide.

L’autre jour, j’ai lu le paragraphe suivant et je ne pouvais pas être plus d’accord à ce sujet : la société d’hébergement Web ne devrait rien faire pour nuire à la réputation de référencement de vos sites Web, sans parler de supprimer l’intégralité de votre site sans vos autorisations. Les fasthosts sont juste au-dessus de la limite et c’est pourquoi les fasthosts ont reçu tant de mauvaises critiques (quelque chose comme des ordures, de la merde, s’évader toute la vie).

Au fait, j’utilise QuickHostUK, qui est tout simplement le meilleur. Le VPS fonctionne très bien et j’ai déjà déplacé quelques sites.