Stoppa Angry Bots som 360Spider till Crawel My Site

Min webbplats steakovercooked.com har varit på en av fasthosts delade värdservrar. Nyligen har min sida inaktiverats många gånger på grund av ett stort antal förfrågningar till min sida. Dessa kommer huvudsakligen från bot som genomsöker webbplatsen. Fasthosts IT Operations Engineer Ewan MacDonald mailade mig och han sa:

Kära justyy

Jag är inte säker på vad du gör med din webbplats exakt men du har förbrukat över 75 % av de tillgängliga Apache-processerna. Detta har orsakat enorma problem för alla andra kunder på webbservern.

Jag kör en säkerhetsskanning mot din webbplats just nu.

Observera att din webbplats innehåller 85 000 motsvarande 8,6 GB. Våra villkor säger att alla filer i ditt webbutrymme måste vara en del av webbplatsen så är alla 85 000 filer en del av webbplatsen och tillgängliga via webbplatsen? Om inte, måste de tas bort tack.

Jag kommer också att ta bort de två omdöpta htdocs-mapparna om du inte invänder?

Om din webbplats orsakar samma prestandaproblem medan skanningen körs kommer jag att ta den offline igen tills du kan ge en förklaring till varför den binder upp cirka 200 Apache-processer.

Vänliga hälsningar,

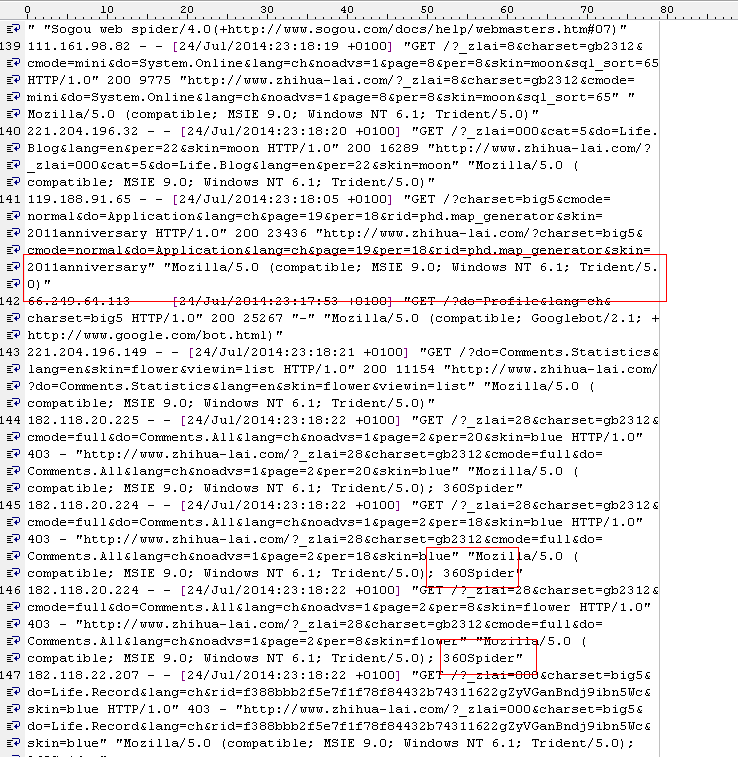

Sedan kollade jag apache2- loggen och jag hittar massor av dessa:

[Wed Jul 23 21:40:21 2014] [warn] mod_fcgid: kan inte tillämpa processplats för /var/www/fcgi/php54-cgi

[Wed Jul 23 21:40:22 2014] [warn] mod_fcgid: can inte tillämpa processplats för /var/www/fcgi/php54-cgi

[onsdag 23 jul 21:40:30 2014] [warn] mod_fcgid: kan inte tillämpa processplats för /var/www/fcgi/php54-cgi

[ Wed Jul 23 21:40:31 2014] [warn] mod_fcgid: kan inte tillämpa processplats för /var/www/fcgi/php54-cgi

[Wed Jul 23 21:40:31 2014] [warn] mod_fcgid: can’ t tillämpa processplats för /var/www/fcgi/php54-cgi

[on jul 23 21:40:31 2014] [warn] mod_fcgid: kan inte tillämpa processplats för /var/www/fcgi/php54-cgi

Tydligen ser det ut som att 360spider träffade webbplatsen ganska hårt och det påverkar uppenbarligen andra webbplatser på samma delade värd, och det är därför fasthosts måste ta ner min webbplats.

360spider-problemet har återkommit senare så de har varit tvungna att inaktivera min webbplats igen tills jag har ett skript redo att blockera dess åtkomst eftersom det orsakar problem för andra användare av servern.

Jag är ledsen att detta orsakar problem för andra delvärdar, men enligt min mening kan det vara bättre att blockera dem med en högre nivå (t.ex. apache-inställningar). Föreställ dig bara, alla andra webbplatser kan möta samma problem. Jag har optimerat min webbplats tidigare för att minska CPU-användningen genom att cacha dem till statiska HTML-filer. men på grund av ett ganska stort antal sidor (cirka 5000 rapporterade i google webmaster) kanske vissa spindlar inte är smarta nog att lista ut duplikatet. Googles spindlar är bra eftersom jag kan konfigurera parametrarna och de följer robots.txt-filen. Men för dessa arga spindlar (t.ex. 360, youdao) följer de faktiskt inte helt reglerna för genomsökning.. Det enda sättet att förbjuda dem är att markera dem i den svarta listan (det kan jag göra med säkerhet). men för andra användare kan de möta samma problem.

robots.txt

Robots.txt är en textfil under roten på webbplatsen som styr sökrobotarna vilka kataloger som ska indexeras och vilka som inte är tillåtna. Men inte alla bots följer "instruktionerna". Här är reglerna jag lägger till för att berätta för dessa dåliga bots försvinner.

# root

User-agent: *

Crawl-Delay: 1

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

User-agent: 360Spider

Disallow: /

User-agent: YoudaoBot

Disallow: /

User-agent: sogou spider

Disallow: /

User-agent: YisouSpider

Disallow: /

User-agent: LinksCrawler

Disallow: /

User-agent: EasouSpider

Disallow: /.htaccess

Filen .htaccess är en textfil och en dold fil i varje webbplatskatalog. Den används av apache re-write modulen mod_rewrite för att få webbadresser att se snyggare ut. Den kan också användas för att kontrollera dessa bots.

PHP-kod

Som en säkerhetsåtgärd har jag även lagt följande kod på index.php som används för att generera olika sidor enligt URL-parametrarna. 99% webbsidor genereras med denna indexfil.

$agent='';

if (isset($_SERVER['HTTP_USER_AGENT']))

{

$agent = $_SERVER['HTTP_USER_AGENT'];

}

define('BADBOTS','/(yisouspider|easouspider|yisou|youdaobot|yodao|360|linkscrawler|soguo)/i');

if (preg_match(BADBOTS, $agent)) {

die();

} I grund och botten, vad ovanstående PHP gör är att kontrollera HTTP_USER_AGENT- strängen mot dessa dåliga bots. Preg_match använder reguljärt uttryck och alternativet /i anger skiftlägesokänsliga jämförelser.

Jag har också märkt i loggfilen, det finns ganska många sådana här poster:

119.188.91.121 – – [24/Jul/2014:22:39:51 +0100] “GET /?charset=big5&do=System.Online&lang=ch&page =25&per=10&skin=2011årsjubileum HTTP/1.0" 200 3919 ” https://steakovercooked.com/ … …" “~Mozilla/5.0 (kompatibel; MSIE 9.0; Windows NT 6.1; Trident/5.0)~”

Från HTTP_USER_AGENT tror du normalt att det inte är en bot, men jag tror att de är det. Så dessa bots är väldigt dåliga. De kommer faktiskt att ge vad som helst USER_AGENT (de kan ändra detta värde) och de är vanligtvis från flera IP-adresser (så det är inte lätt att identifiera alla med specifika IP-intervall).

Det verkar fungera efter ovanstående metoder.

det verkar fungera, för i apacheloggen hittar jag många av dessa

[Thu Jul 24 23:01:02 2014] [fel] [klient 61.135.189.186] som nekats av serverkonfigurationen: /home/linweb09/z/steakovercooked. com-1048918357/user/htdocs/

[tors 24 jul 2014] [fel] [klient 61.135.189.186] klient nekad av serverkonfiguration: /home/linweb09/z/steakovercooked.com/857docs /error

[Thu Jul 24 23:01:08 2014] [fel] [klient 61.135.189.186] klient nekad av serverkonfiguration: /home/linweb09/z/steakovercooked.com-1048918357/user/htdocs/

Och snabbvärdarna är också glada: "Japp, det ser mycket mycket bättre ut nu. så jag stänger den här biljetten. Stort tack för ditt agerande."

Men det här kanske inte är en slutgiltig lösning… Så småningom kommer jag också att flytta denna sida till VPS, lastbalanseringsservrar eller dedikerad server så att den inte tas ner på grund av denna dumma anledning.

Häromdagen läste jag följande stycke och jag kunde inte hålla med mer om detta: Webbhotellet bör INTE göra något för att skada din webbplats SEO- rykte, för att inte tala om, ta ner hela din webbplats utan dina tillstånd. Fasthosts är bara långt över gränsen och det är därför fasthosts fick så många dåliga recensioner (något som skräp, skit, komma undan för hela livet).

Förresten, jag använder QuickHostUK, som helt enkelt är bäst. VPS fungerar bara bra och jag har redan flyttat över ett par sajter.