Minu veebisait steakovercooked.com on olnud ühes kiirhosti jagatud hostimisserveris. Hiljuti on minu sait mitu korda keelatud, kuna minu saidile on esitatud tohutult palju taotlusi. Need tulenevad peamiselt saidil roomavast robotist. Fasthosti IT-operatsioonide insener Ewan MacDonald saatis mulle meili ja ütles:

Kallis justyy

Ma pole kindel, mida te oma saidiga täpselt teete, kuid olete kasutanud üle 75% saadaolevatest Apache protsessidest. See on põhjustanud suuri probleeme kõigile teistele veebiserveri klientidele.

Käivitan praegu teie saidi turvakontrolli.

Pange tähele, et teie sait sisaldab 85 000, mis ulatub 8,6 GB-ni. Meie tingimuste kohaselt peavad kõik teie veebiruumis olevad failid olema veebisaidi osa, seega kas kõik 85 000 faili on saidi osa ja saidi kaudu juurdepääsetavad? Kui ei, siis tuleb need eemaldada.

Ma eemaldan ka 2 ümbernimetatud htdocsi kausta, kui te ei vaidle vastu?

Kui teie sait põhjustab skannimise ajal sama jõudlusprobleemi, võtan selle uuesti võrguühenduseta, kuni saate selgitada, miks see seob umbes 200 Apache protsessi.

Parimate soovidega,

Seejärel kontrollisin apache2 logi ja leidsin palju järgmist:

[Wed Jul 23 21:40:21 2014] [hoiata] mod_fcgid: ei saa rakendada protsessi pesa /var/www/fcgi/php54-cgi jaoks

[Wed Jul 23 21:40:22 2014] [hoiata] mod_fcgid: saab ‘ei rakenda /var/www/fcgi/php54-cgi jaoks protsessipesa

[Wed Jul 23 21:40:30 2014] [hoiatus] mod_fcgid: ei saa rakendada protsessipesa /var/www/fcgi/php54-cgi

[ Kolmapäev, 23. juuli 21:40:31 2014] [hoiatus] mod_fcgid: /var/www/fcgi/php54-cgi jaoks ei saa protsessipesa rakendada

[Wed Jul 23 21:40:31 2014] [hoiata] mod_fcgid: can’ t rakenda protsessipesa /var/www/fcgi/php54-cgi jaoks

[Wed Jul 23 21:40:31 2014] [hoiatus] mod_fcgid: ei saa rakendada protsessipesa /var/www/fcgi/php54-cgi jaoks

Ilmselt tundub, et 360spider tabas saiti üsna tugevalt ja see mõjutab ilmselgelt ka teisi sama jagatud hosti veebisaite ning seetõttu peavad kiirhostid minu saidi maha võtma.

360spideri probleem ilmnes hiljem, nii et nad on pidanud mu saidi uuesti keelama, kuni mul on valmis skript sellele juurdepääsu blokeerimiseks, kuna see põhjustab probleeme serveri teistele kasutajatele.

Mul on kahju, et see tekitab probleeme teistele jagamismasinatele, kuid minu arvates võib olla parem blokeerida nad kõrgema taseme abil (nt apache seaded). Kujutage vaid ette, sama probleemiga võivad kokku puutuda ka teised veebisaidid. Olen oma veebisaiti varem optimeerinud, et vähendada CPU kasutust, salvestades need staatilistele HTML-idele. kuid üsna paljude lehekülgede tõttu (umbes 5000 google webmasteri andmetel) ei pruugi mõned ämblikud olla piisavalt targad, et duplikaati välja selgitada. Google’i ämblikud on korras, sest ma saan parameetreid seadistada ja nad järgivad faili robots.txt. Aga nende vihaste ämblike puhul (nt 360, youdao) nad tegelikult ei allu roomamisreeglitele. Ainus viis nende keelamiseks on märkida nad musta nimekirja (seda saan ma kindlasti teha). kuid teised kasutajad võivad sama probleemiga kokku puutuda.

robots.txt

Robots.txt on veebisaidi juure all olev tekstifail, mis suunab otsingurobotid, milliseid katalooge indekseerida ja millised mitte. Kuid mitte kõik robotid ei järgi "juhiseid". Siin on reeglid, mille lisan, et öelda, et need halvad robotid kaovad.

# root

User-agent: *

Crawl-Delay: 1

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

User-agent: 360Spider

Disallow: /

User-agent: YoudaoBot

Disallow: /

User-agent: sogou spider

Disallow: /

User-agent: YisouSpider

Disallow: /

User-agent: LinksCrawler

Disallow: /

User-agent: EasouSpider

Disallow: /.htaccess

Fail .htaccess on teksti- ja peidetud fail igas veebisaidi kataloogis. Seda kasutab apache ümberkirjutamise moodul mod_rewrite, et muuta URL-id ilusamaks. Seda saab kasutada ka nende robotite juhtimiseks.

PHP kood

Ettevaatusabinõuna panin indeks.php -sse ka järgmise koodi, mida kasutatakse erinevate lehtede genereerimiseks vastavalt URL-i parameetritele. 99% veebisaidi lehtedest luuakse selle registrifaili abil.

$agent='';

if (isset($_SERVER['HTTP_USER_AGENT']))

{

$agent = $_SERVER['HTTP_USER_AGENT'];

}

define('BADBOTS','/(yisouspider|easouspider|yisou|youdaobot|yodao|360|linkscrawler|soguo)/i');

if (preg_match(BADBOTS, $agent)) {

die();

} Põhimõtteliselt kontrollib ülaltoodud PHP stringi HTTP_USER_AGENT nende halbade robotite suhtes. Preg_match kasutab regulaaravaldist ja valik /i määrab tõstutundlikud võrdlused.

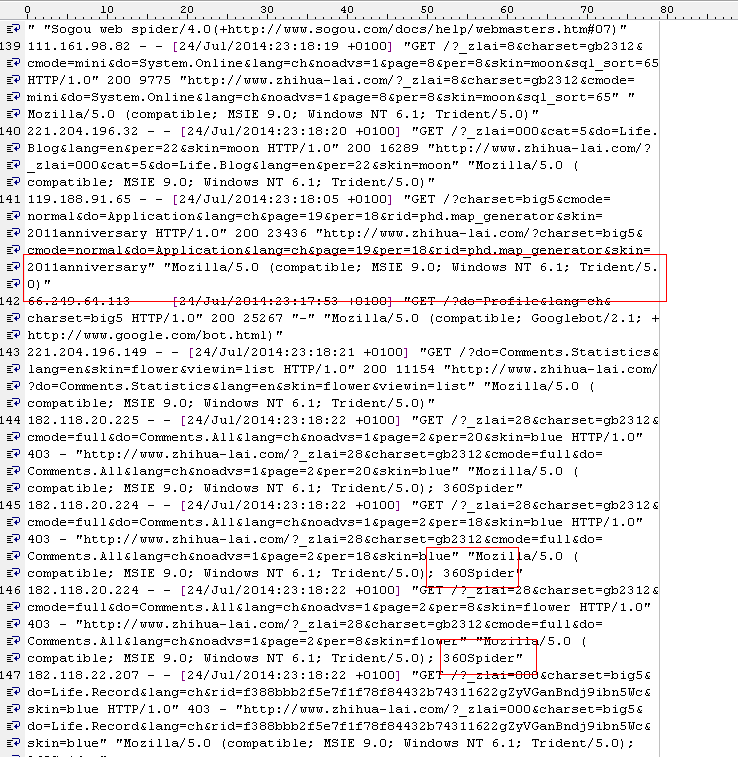

Olen ka logifailis märganud, et selliseid kirjeid on päris palju:

119.188.91.121 – – [24/Jul/2014:22:39:51 +0100] “GET /?charset=big5&do=System.Online&lang=ch&page =25&per=10&skin=2011aastapäev HTTP/1.0" 200 3919 " https://steakovercooked.com/ … …" "~Mozilla/5.0 (ühildub; MSIE 9.0; Windows NT 6.1; Trident/5.0)~"

HTTP_USER_AGENTist arvate tavaliselt, et see pole robot, kuid ma arvan, et nad on seda. Nii et need robotid on väga halvad. Nad annavad tegelikult mis tahes USER_AGENT (nad saavad seda väärtust muuta) ja need on tavaliselt mitmest IP-st (seega pole neid kõiki konkreetsete IP-vahemike abil lihtne tuvastada).

Tundub, et see töötab pärast ülaltoodud meetodeid.

tundub, et see töötab, sest ma leian apache logist palju selliseid

[Thu Jul 24 23:01:02 2014] [viga] [klient 61.135.189.186] serveri konfiguratsiooniga keelatud klient: /home/linweb09/z/steakovercooked. com-1048918357/user/htdocs/

[Th Jul 24 23:01:02 2014] [viga] [klient 61.135.189.186] klient keelatud serveri konfiguratsiooni tõttu: /home/linweb09/z/steakovercooked. /error

[Thu Jul 24 23:01:08 2014] [viga] [klient 61.135.189.186] klient on serveri konfiguratsiooni tõttu keelatud: /home/linweb09/z/steakovercooked.com-1048918357/user/htdocs

Ja ka kiirhostid on rahul: “Jah, nüüd näeb palju parem välja. nii et ma sulgen selle pileti. Suur tänu teie tegevuse eest. "

Kuid see ei pruugi olla lõplik lahendus… Lõpuks kolin selle saidi ka VPS -i, koormuse tasakaalustamise serveritesse või spetsiaalsesse serverisse, et seda rumala põhjuse tõttu maha ei võetaks.

Teisel päeval lugesin ma järgmist lõiku ja ma ei suutnud selles enam nõustuda: Veebimajutusettevõte EI TOHI midagi teie veebisaitide SEO maine kahjustamiseks teha, rääkimata kogu teie saidi ilma teie lubadeta allakäigust. Kiirhostid on napilt üle piiri ja seetõttu said kiirhostid nii palju halbu arvustusi (miski nagu prügi, jama, kogu eluks minema).

Muide, ma kasutan QuickHostUK-i, mis on lihtsalt parim. VPS töötab lihtsalt suurepäraselt ja olen juba paar saiti teisaldanud.