Stoppen Sie wütende Bots wie 360Spider, um meine Website zu crawlen

Meine Website steakovercooked.com war auf einem der Shared-Hosting-Server von fasthosts. In letzter Zeit wurde meine Website viele Male aufgrund einer großen Anzahl von Anfragen an meine Website deaktiviert. Diese stammen hauptsächlich von Bots, die die Website crawlen. Ewan MacDonald, IT Operations Engineer von Fasthosts, schickte mir eine E-Mail und sagte:

Liebe justyy

Ich bin mir nicht sicher, was Sie genau mit Ihrer Website machen, aber Sie haben über 75 % der verfügbaren Apache-Prozesse verbraucht. Dies hat allen anderen Kunden auf dem Webserver massive Probleme bereitet.

Ich führe derzeit einen Sicherheitsscan Ihrer Website durch.

Bitte beachten Sie, dass Ihre Website 85.000 in Höhe von 8,6 GB enthält. Unsere Bedingungen besagen, dass alle Dateien in Ihrem Webspace Teil der Website sein müssen. Sind also alle 85.000 Dateien Teil der Website und über die Website zugänglich? Wenn nicht, müssen sie bitte entfernt werden.

Ich werde auch die 2 umbenannten htdocs-Ordner entfernen, es sei denn, Sie widersprechen?

Wenn Ihre Website das gleiche Leistungsproblem verursacht, während der Scan ausgeführt wird, werde ich sie wieder offline schalten, bis Sie eine Erklärung dafür liefern können, warum sie ungefähr 200 Apache-Prozesse blockiert.

Mit freundlichen Grüßen,

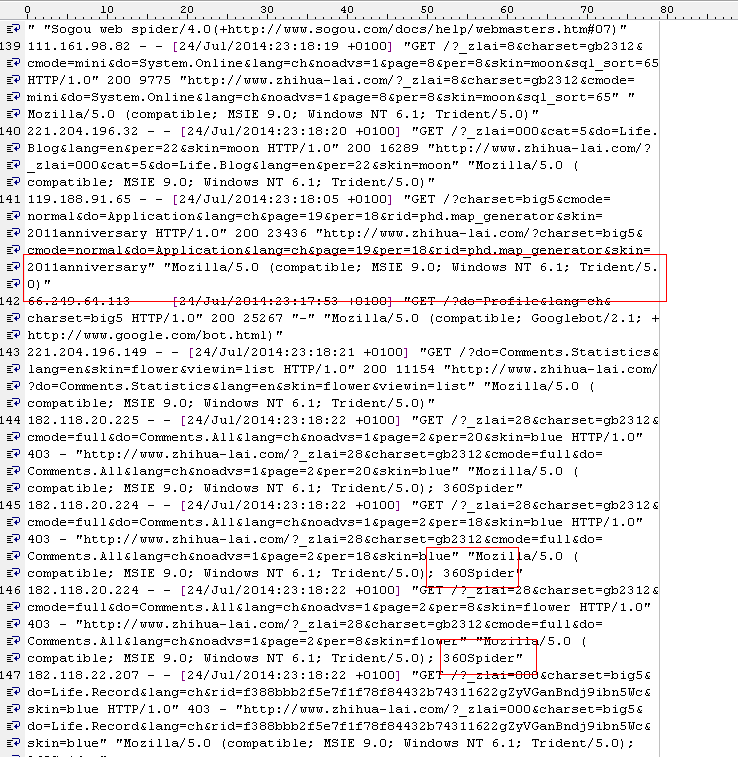

Dann habe ich das Apache2 -Protokoll überprüft und viele davon gefunden:

[Mi 23. Juli 21:40:21 2014] [Warnung] mod_fcgid: Prozess-Slot kann nicht für /var/www/fcgi/php54-cgi angewendet werden

[Mi 23. Juli 21:40:22 2014] [Warnung] mod_fcgid: can Prozess-Slot für /var/www/fcgi/php54-cgi

nicht anwenden [Mi 23. Juli 21:40:30 2014] [Warnung] mod_fcgid: Prozess-Slot für /var/www/fcgi/php54-cgi kann nicht angewendet werden

[ Wed Jul 23 21:40:31 2014] [Warnung] mod_fcgid: Prozess-Slot für /var/www/fcgi/php54-cgi kann nicht angewendet werden

[Mi 23. Juli 21:40:31 2014] [Warnung] mod_fcgid: kann’ Prozess-Slot für /var/www/fcgi/php54-cgi

nicht anwenden [Mi 23. Juli 21:40:31 2014] [Warnung] mod_fcgid: Prozess-Slot kann nicht für /var/www/fcgi/php54-cgi angewendet werden

Anscheinend sieht es so aus, als ob 360spider die Site ziemlich stark getroffen hat und offensichtlich andere Websites auf demselben Shared-Host betrifft, und deshalb müssen die Fasthosts meine Site herunterfahren.

Das 360spider-Problem ist später zurückgekehrt, sodass sie meine Website erneut deaktivieren mussten, bis ich ein Skript bereit habe, um den Zugriff zu blockieren, da es anderen Benutzern des Servers Probleme bereitet.

Es tut mir leid, dass dies anderen Share-Hosts Probleme bereitet, aber meiner Meinung nach könnte es besser sein, sie mit einer höheren Ebene (z. B. Apache-Einstellungen) zu blockieren. Stellen Sie sich vor, andere Websites könnten dasselbe Problem haben. Ich habe meine Website zuvor optimiert, um die CPU-Auslastung zu reduzieren, indem ich sie in statische HTMLs zwischenspeicherte. Aber aufgrund der großen Anzahl von Seiten (ca. 5000 gemeldet in Google Webmaster) sind einige Spinnen möglicherweise nicht schlau genug, um das Duplikat herauszufinden. Google-Spider sind in Ordnung, weil ich die Parameter konfigurieren kann und sie der robots.txt-Datei gehorchen. Aber für diese wütenden Spinnen (zB 360, youdao) halten sie sich eigentlich nicht ganz an die Crawling-Regeln. Die einzige Möglichkeit, sie zu verbieten, besteht darin, sie in der schwarzen Liste zu markieren (das kann ich sicher tun). aber für andere Benutzer stehen sie möglicherweise vor dem gleichen Problem.

robots.txt

Die robots.txt ist eine Textdatei im Stammverzeichnis der Website, die den Suchbots mitteilt, welche Verzeichnisse indiziert werden sollen und welche nicht. Aber nicht alle Bots befolgen die „Anweisungen”. Hier sind die Regeln, die ich hinzufüge, um diesen bösen Bots zu sagen, dass sie verschwinden.

# root

User-agent: *

Crawl-Delay: 1

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

User-agent: 360Spider

Disallow: /

User-agent: YoudaoBot

Disallow: /

User-agent: sogou spider

Disallow: /

User-agent: YisouSpider

Disallow: /

User-agent: LinksCrawler

Disallow: /

User-agent: EasouSpider

Disallow: /.htaccess

Die Datei .htaccess ist eine Text- und versteckte Datei in jedem Website-Verzeichnis. Es wird vom Apache Rewrite-Modul mod_rewrite verwendet, um URLs schöner aussehen zu lassen. Es kann auch verwendet werden, um diese Bots zu steuern.

PHP-Code

Als Sicherheitsvorkehrung habe ich auch den folgenden Code in die index.php eingefügt, der verwendet wird, um verschiedene Seiten gemäß den URL-Parametern zu generieren. 99 % der Webseiten werden mit dieser Indexdatei generiert.

$agent='';

if (isset($_SERVER['HTTP_USER_AGENT']))

{

$agent = $_SERVER['HTTP_USER_AGENT'];

}

define('BADBOTS','/(yisouspider|easouspider|yisou|youdaobot|yodao|360|linkscrawler|soguo)/i');

if (preg_match(BADBOTS, $agent)) {

die();

} Im Grunde überprüft das obige PHP den HTTP_USER_AGENT -String auf diese bösartigen Bots. Das preg_match verwendet einen regulären Ausdruck und die Option /i gibt Vergleiche ohne Berücksichtigung der Groß-/Kleinschreibung an.

Mir ist auch aufgefallen, dass in der Logdatei ziemlich viele Einträge wie dieser stehen:

119.188.91.121 – – [24/Jul/2014:22:39:51 +0100] „GET /?charset=big5&do=System.Online&lang=ch&page =25&per=10&skin=2011anniversary HTTP/1.0" 200 3919 ” https://steakovercooked.com/ … …" “~Mozilla/5.0 (kompatibel; MSIE 9.0; Windows NT 6.1; Trident/5.0)~”

Vom HTTP_USER_AGENT denken Sie normalerweise, dass es kein Bot ist, aber ich denke, dass sie es sind. Diese Bots sind also sehr schlecht. Sie geben tatsächlich einen beliebigen USER_AGENT an (sie können diesen Wert ändern) und sie stammen normalerweise von mehreren IPs (daher ist es nicht einfach, alle anhand bestimmter IP-Bereiche zu identifizieren).

Es scheint nach den oben genannten Methoden zu funktionieren.

es scheint zu funktionieren, denn im Apache-Protokoll finde ich viele dieser

[Do Jul 24 23:01:02 2014] [error] [client 61.135.189.186] client denied by server configuration: /home/linweb09/z/steakovercooked. com-1048918357/user/htdocs/

[Donnerstag, 24. Juli, 23:01:02 2014] [Fehler] [Client 61.135.189.186] Client von Serverkonfiguration verweigert: /home/linweb09/z/steakovercooked.com-1048918357/user/htdocs /error

[Do Jul 24 23:01:08 2014] [Fehler] [Client 61.135.189.186] Client von Serverkonfiguration verweigert: /home/linweb09/z/steakovercooked.com-1048918357/user/htdocs/

Und auch der Fasthoster freut sich: „Ja, jetzt sieht es viel viel besser aus. Also schließe ich dieses Ticket. Vielen Dank für Ihre Aktion.”

Dies ist jedoch möglicherweise keine endgültige Lösung … Irgendwann werde ich diese Site auch auf VPS, Load-Balancing-Server oder dedizierte Server verschieben, damit sie nicht aus diesem dummen Grund heruntergefahren wird.

Neulich habe ich den folgenden Absatz gelesen und konnte dem nicht mehr zustimmen: Das Webhosting-Unternehmen sollte NICHTS tun, um den SEO – Ruf Ihrer Website zu schädigen, ganz zu schweigen davon, Ihre gesamte Website ohne Ihre Erlaubnis herunterzufahren. Fasthosts ist einfach weit über dem Strich und deshalb hat Fasthosts so viele schlechte Bewertungen bekommen (so etwas wie Müll, Mist, weg fürs ganze Leben).

Übrigens verwende ich QuickHostUK, was einfach das Beste ist. Der VPS funktioniert einfach großartig und ich habe bereits ein paar Websites umgezogen.